Написати нам

Що відбувалося з українським eCommerce у другому півріччі 2025? Аналізуємо доходи, трафік, середній чек і канали залучення — ключові висновки та тенденції ринку.

Все про AI Max у Google Ads: Як працює штучний інтелект від Google для оптимізації пошукових кампаній, що варто врахувати перед запуском AI Max та яких результатів очікувати.

Як рекламувати інтернет-магазин через SEO, контекстну рекламу, email-маркетинг та медіа. Комплексний підхід для реклами інтернет-магазину допоможе як розкрутити онлайн бізнес та швидко збільшити трафік і продажі.

Мета Андромеда: що бізнесу потрібно знати про новий AI-алгоритм Meta, які зміни в налаштуваннях реклами та як адаптуватись, щоб отримати максимум результату без зливу бюджету.

Хто очолює рейтинг брендів в Україні? Ми зібрали лідерів різних ніш за кількістю пошукових запитів — дізнайтеся, хто №1 у 2025 році.

Аналіз пошукових запитів про подарунки на 8 березня: що можна подарувати на Міжнародний жіночий день, які ідеї подарунку на 8 березня шукають українці та що дарують жінкам, дівчатам, мамам, колегам та подругам найчастіше.

Promodo проаналізувала пошукові запити «як готувати кутю», щоб з’ясувати, як українці перейшли на святкування Різдва 25 грудня. Коротке міні-дослідження з даними.

Black Friday 2025 в Україні: як змінилися витрати, що купували українці в яких категоріях та як зріс дохід ритейлерів. Дослідження Promodo та eSputnik

ChatGPT генерує трафік і прямі продажі для українських онлайн-магазинів. Дослідження Promodo показує, які категорії перші отримують користь від рекомендацій в ШІ.

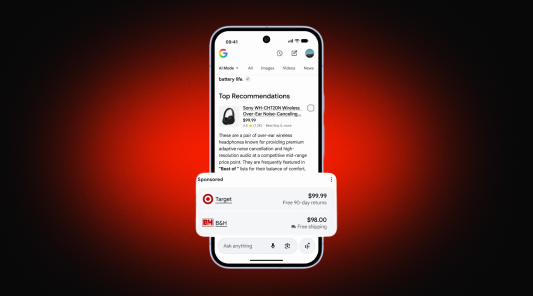

Революція в Google Search: реклама всередині відповідей ШІ та купівля товарів без переходу на сайт. Розбираємо деталі запусків у США та перспективи для України.

Чому подарункові бокси стали трендом Дня закоханих? Що найчастіше дарують українці своїм коханим на День святого Валентина: дослідження попиту подарунків до 14 лютого.

Як AI допомагає покупцям в інтернет-магазині: кейси персоналізації, AI-чатів і рекомендацій для спрощення вибору та зростання продажів в e-commerce.

Як рекламувати інтернет-магазин через SEO, контекстну рекламу, email-маркетинг та медіа. Комплексний підхід для реклами інтернет-магазину допоможе як розкрутити онлайн бізнес та швидко збільшити трафік і продажі.

Мета Андромеда: що бізнесу потрібно знати про новий AI-алгоритм Meta, які зміни в налаштуваннях реклами та як адаптуватись, щоб отримати максимум результату без зливу бюджету.