Написати нам

Що відбувалося з українським eCommerce у другому півріччі 2025? Аналізуємо доходи, трафік, середній чек і канали залучення — ключові висновки та тенденції ринку.

ChatGPT генерує трафік і прямі продажі для українських онлайн-магазинів. Дослідження Promodo показує, які категорії перші отримують користь від рекомендацій в ШІ.

Програма лояльності в eCommerce допомагає утримувати клієнтів, збільшувати середній чек і стимулювати повторні покупки. Огляд видів, принципів роботи та поради щодо створення ефективної програми великих онлайн-магазинів.

Дізнайтеся, як провести ефективний аудит Google Ads у 2025 році: від перевірки GA4 та Performance Max до оптимізації ключових слів, оголошень і Shopping-фіду. Практичні поради, приклади з реальних проєктів і готовий чек-лист для підвищення ROAS та зниження CPA.

Хто очолює рейтинг брендів в Україні? Ми зібрали лідерів різних ніш за кількістю пошукових запитів — дізнайтеся, хто №1 у 2025 році.

Promodo проаналізувала пошукові запити «як готувати кутю», щоб з’ясувати, як українці перейшли на святкування Різдва 25 грудня. Коротке міні-дослідження з даними.

Black Friday 2025 в Україні: як змінилися витрати, що купували українці в яких категоріях та як зріс дохід ритейлерів. Дослідження Promodo та eSputnik

ChatGPT генерує трафік і прямі продажі для українських онлайн-магазинів. Дослідження Promodo показує, які категорії перші отримують користь від рекомендацій в ШІ.

.avif)

Promodo дослідила, коли і якою мовою українці шукають онлайн-курси. Сезонність, тренди, ніші зростання та поради для EdTech-бізнесів.

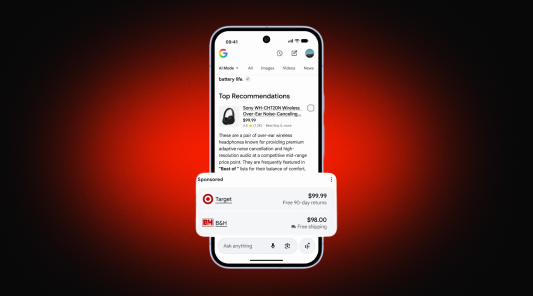

Революція в Google Search: реклама всередині відповідей ШІ та купівля товарів без переходу на сайт. Розбираємо деталі запусків у США та перспективи для України.

Як AI допомагає покупцям в інтернет-магазині: кейси персоналізації, AI-чатів і рекомендацій для спрощення вибору та зростання продажів в e-commerce.

Як рекламувати інтернет-магазин через SEO, контекстну рекламу, email-маркетинг та медіа. Комплексний підхід для реклами інтернет-магазину допоможе як розкрутити онлайн бізнес та швидко збільшити трафік і продажі.

Мета Андромеда: що бізнесу потрібно знати про новий AI-алгоритм Meta, які зміни в налаштуваннях реклами та як адаптуватись, щоб отримати максимум результату без зливу бюджету.

Дізнайтесь, що таке zombie-SKU, як їх знайти в рекламі та асортименті й як перетворити товари, що не продаються, на джерело прибутку.